人工智能已正式进入工业化应用阶段,“AI工厂”这一全新产业范式逐步成型——它不再是间歇性启动的模型训练任务,而是全天候不间断产出智能能力的高效运作系统。然而,这一产业升级过程中,传统计算架构暴露出三大关键性缺陷:当前主流AI应用以“长上下文处理”“智能体工作流协同”为核心诉求,不仅需要超强算力支撑,更对内存带宽、数据通信延迟提出了复合型高要求。当智能体执行复杂任务时,需在多步推理环节中持续维系海量上下文信息,而任何一个环节的延迟卡顿,在万亿级令牌的大规模处理场景中都会被无限放大。

驱动AI技术迭代的“三大扩展法则”——预训练扩展(依托海量数据完成基础学习)、训练后扩展(通过微调强化模型思考能力)、测试时扩展(推理过程中生成更多令牌),直接推动了对计算资源的指数级需求增长。以往单纯“堆叠服务器”的横向扩展模式,早已陷入通信成本激增、算力效率递减的瓶颈。传统架构的“组件孤岛”设计思路,导致CPU、GPU、网络等核心部件各自独立优化,数据在不同组件间流转时损耗严重,理论上的峰值性能始终无法在实际生产场景中充分释放。正是这些行业痛点,催生了英伟达鲁宾平台(Rubin)的革命性设计(CES 2026:英伟达Rubin架构深度解析,详解GPU“六芯合一”AI超级计算方案)——该平台摒弃了单一组件优化的传统思路,将整个数据中心作为一个统一的计算单元进行整体设计,从根源上解决了AI工厂在规模扩张、效率提升、安全保障与成本控制方面的核心难题。

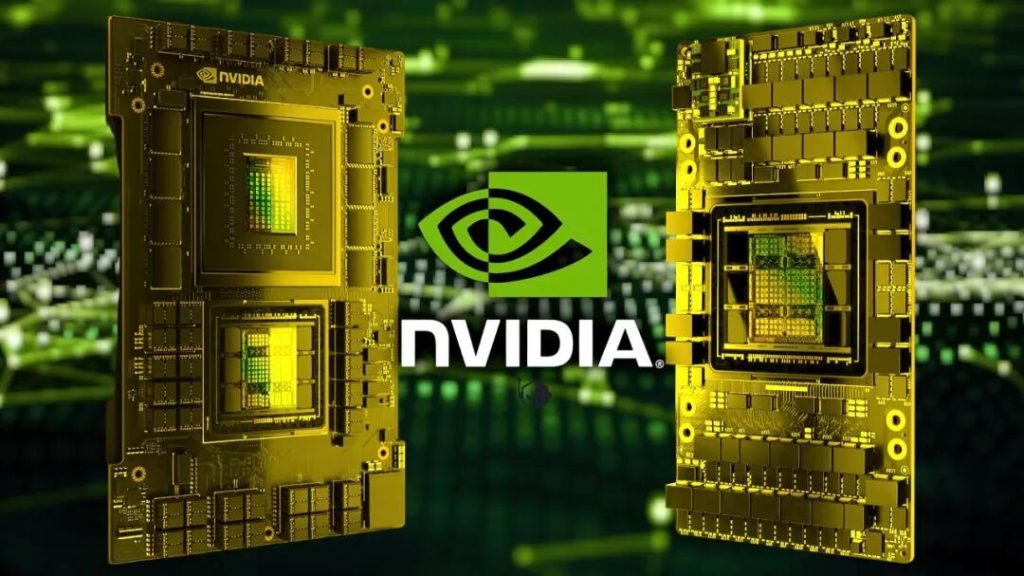

一、全栈协同设计:六款核心芯片构筑算力生态底座

鲁宾平台(Rubin)的核心竞争力,源于其“从芯片到系统”的全栈协同架构。六款全新研发的核心芯片各司其职且无缝联动,共同构成了AI工厂的基础设施骨架:

1. Vera CPU:AI工厂的数据调度核心

不同于传统通用型CPU,Vera CPU是专为GPU高效“供数”设计的高带宽数据传输引擎。其搭载88个自研Olympus核心,结合空间多线程技术,在实现吞吐量翻倍的同时,保障了多租户使用场景下的资源隔离;1.2TB/s的内存带宽与1.5TB LPDDR5X内存容量,确保数据无需等待即可直接传输至GPU;1.8TB/s的NVLink-C2C带宽,实现了CPU与GPU内存的统一寻址,从根本上消除了数据移动过程中的性能损耗。

2. Rubin GPU:Transformer时代的算力执行核心

作为AI工厂的核心生产力部件,Rubin GPU跳出了传统仅追求浮点算力的认知误区。其集成3360亿晶体管,搭载224个流式多处理器,第三代Transformer引擎实现了硬件级加速的自适应压缩功能,NVFP4精度下的推理性能高达50 PFLOPS,是上一代产品的5倍;率先采用HBM4内存,单卡带宽达到22TB/s,为长上下文推理场景提供了坚实的硬件支撑。

3. NVLink 6 Switch:机架内的高速通信神经网络

通信效率直接决定GPU算力的利用率,NVLink 6 Switch将72个GPU连接成一个紧密耦合的超级加速器。每个GPU拥有3.6TB/s的双向通信带宽,全互联拓扑结构确保任意两个GPU可直接实现数据交互,彻底解决了MoE模型推理过程中产生的指数级通信需求;更集成了网络内计算功能,交换机自身可提供14.4 TFLOPS的算力,大幅减少了数据传输总量。

4. ConnectX-9 SuperNIC:跨机架通信的智能网关

当AI工厂规模突破单个机架限制时,ConnectX-9 SuperNIC成为保障性能稳定的关键部件。其单机架带宽可达1.6Tb/s,搭配可编程拥塞控制技术,能够主动预防网络拥堵;在多租户共享环境中,可实现严格的流量隔离,确保不同任务的性能互不干扰,让共享基础设施也能提供稳定的服务质量。

5. BlueField-4 DPU:AI工厂的基础设施管家

如果说CPU和GPU是算力核心,那么BlueField-4 DPU就是AI工厂的“全能管家”。其搭载64核Arm核心,带宽达到800Gb/s,可将网络、存储、安全等基础设施相关功能从核心计算任务中完全卸载,让Vera CPU和Rubin GPU能够专注于核心算力输出;其独创的推理上下文存储技术,可将长上下文智能体的令牌处理速度提升5倍。

6. Spectrum-6 Ethernet Switch:跨数据中心的连接桥梁

为支撑AI工厂的跨机架、跨数据中心扩展,Spectrum-6交换机借助硅光子技术实现了革命性突破:102.4Tb/s的交换容量,是上一代产品的2倍;能效提升5倍,可节省兆瓦级电力消耗;信号完整性提升64倍,大幅增强了大规模集群的运行可靠性,为部署数万个GPU规模的超大型AI工厂奠定了基础。

二、从芯片到工厂:三级集成架构实现即插即用部署

鲁宾平台并非孤立的芯片组合,而是通过三级集成设计,将芯片层面的技术创新转化为可直接部署的生产力解决方案:

1. 基础构建模块:Vera Rubin超算芯片

由2个Rubin GPU与1个Vera CPU通过NVLink-C2C技术紧密集成,构成最小算力单元。数据在单元内部高速流转,大幅提升了异构计算的执行效率。

2. 机架级集成:Vera Rubin NVL72系统

将36个超算芯片(包含72个GPU和36个CPU)整合为一个巨型相干加速器。采用无电缆模块化设计,使设备维护时间缩短18倍;全互联的NVLink 6网络与Spectrum-X以太网相结合,实现了机架内外的无缝扩展。

3. 部署蓝图:DGX SuperPOD

将多个NVL72系统、高性能存储设备与Mission Control管理软件深度集成,形成“交钥匙”式AI工厂解决方案。企业可快速部署数百至数万个GPU规模的基础设施,从部署首日就能实现高效稳定运行。

三、生产级保障体系:安全、可靠、可持续三位一体

AI工厂的核心价值不仅体现在峰值算力,更在于持续稳定的产出能力。鲁宾平台从三个维度构建了全方位的生产级保障体系:

1. 极致可靠性(RAS)

采用机架级模块化热插拔设计,更换组件时无需中断系统整体运行;NVLink智能弹性技术可动态规避故障链路;Rubin GPU内置第二代RAS引擎,能够在线实时修复硬件问题,最大限度提升有效产出。

2. 全栈机密计算

首次将安全保护范围扩展至整个机架,CPU、GPU、NVLink域实现全程硬件加密。从数据进入系统到模型推理输出,全程处于可信执行环境之中,即便在共享云环境下,敏感数据和模型也能有效抵御未授权访问。

3. 超高能效比

采用45℃温水直接液冷技术,大幅降低冷却系统能耗;机架级功率平滑功能可吸收功率波动,使数据中心能够按持续功率规划资源配置;与电池储能系统集成后,可额外部署30%的GPU容量,极致提升了从电网电力到令牌处理的转化效率。

四、量化优势:重塑AI经济学的颠覆性变革

鲁宾平台的核心价值,最终体现在其无可替代的性能优势与成本控制能力上,实现了AI经济学的颠覆性变革:

1. 开启10万亿参数MoE模型时代:训练10万亿参数的MoE模型并处理100万亿令牌时,鲁宾NVL72系统所需的GPU数量仅为上一代产品的1/4。这使得此前难以落地的超大规模模型具备了商业运营可行性,彻底打破了AI创新的算力天花板。

2. 大规模实时推理成本直降10倍:在Kimi-K2-Thinking等“思考型”模型的负载场景下,鲁宾平台每兆瓦电力的令牌吞吐量是上一代产品的10倍;每处理百万令牌的成本降低10倍。这一突破让高智能、长上下文的AI推理服务,从高端定制化场景走向规模化普惠应用。

综上,鲁宾平台的核心创新在于将整个数据中心视作一个统一的计算实体。它以Vera CPU、Rubin GPU等六款核心芯片为基础,通过超算芯片、机架级系统(NVL72)到DGX SuperPOD的三级集成架构,实现了从芯片到系统的全链路高效协同,为AI工厂的规模化、高效化、安全化运营提供了全方位解决方案。

大风热搜网

大风热搜网